Récemment, un certain nombre de vidéos musicales virales d’une chaîne YouTube appelée There I Ruined It ont inclus des voix générées par l’IA d’artistes musicaux célèbres chantant des paroles de chansons surprenantes. Dans un exemple récent, on imagine Elvis chantant les paroles de la chanson de Sir Mix-a-Lot Baby Got Back. Une autre montre un faux Johnny Cash chantant les paroles de Aqua’s Barbie Girl.

(La vidéo originale d’Elvis a depuis été retirée de YouTube en raison d’une revendication de droits d’auteur de la part d’Universal Music Group, mais grâce à la magie de l’internet, vous pouvez quand même l’écouter).

Évidemment, comme Elvis est mort depuis 46 ans (et Cash depuis 20 ans), aucun des deux hommes n’aurait pu chanter les chansons lui-même. C’est là que l’intelligence artificielle entre en jeu. Mais comme nous le verrons, même si l’IA générative peut être étonnante, l’élaboration de ces mélanges musicaux nécessite encore beaucoup de talent et d’efforts de la part des humains.

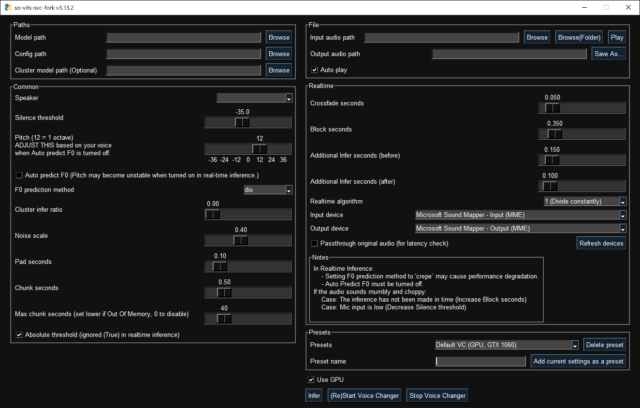

Pour savoir comment Là, j’ai tout gâché nous avons d’abord contacté le créateur de la chaîne, le musicien Dustin Ballard. La réponse de Ballard n’était pas très détaillée, mais il a exposé le processus de base. Il utilise un modèle d’IA appelé so-vits-svc pour transformer les voix qu’il enregistre en celles d’autres artistes. « Ce n’est actuellement pas un processus très convivial (et la formation elle-même est encore plus difficile) », a-t-il déclaré à Ars Technica dans un courriel, « mais en gros, une fois que vous avez le modèle formé (basé sur un large échantillon de références audio propres), vous pouvez télécharger votre propre piste vocale et elle est remplacée par la voix que vous avez modélisée. Vous pouvez ensuite l’intégrer à votre mixage et construire la chanson autour d’elle ».

Mais revenons un instant en arrière : que signifie « so-vits-svc » ? Le nom provient d’une série de technologies open source enchaînées les unes aux autres. La partie « so » vient de « SoftVC » (VC pour « voice conversion »), qui décompose l’audio source (la voix d’un chanteur) en éléments clés qui peuvent être encodés et appris par un réseau neuronal. La partie « VITS » est un acronyme pour « Variational Inference with adversarial learning for end-to-end Text-to-Speech » (inférence variationnelle avec apprentissage contradictoire pour la synthèse vocale de bout en bout), inventé dans cet article de 2021. VITS utilise les connaissances du modèle vocal entraîné et génère la sortie vocale convertie. Et « SVC » signifie « conversion de la voix chantée », c’est-à-dire conversion d’une voix chantée en une autre, par opposition à la conversion de la voix parlée.

La récente Là, j’ai tout gâché utilisent principalement l’IA sur un point : Le modèle d’IA s’appuie sur la performance vocale de Ballard, mais il change le timbre de sa voix en celui de quelqu’un d’autre, de la même manière que la technologie voix à voix de Respeecher peut transformer l’interprétation de Dark Vador par un acteur en la voix de James Earl Jones. Le reste de la chanson provient de l’arrangement de Ballard dans une application musicale classique.

Un processus compliqué – pour l’instant

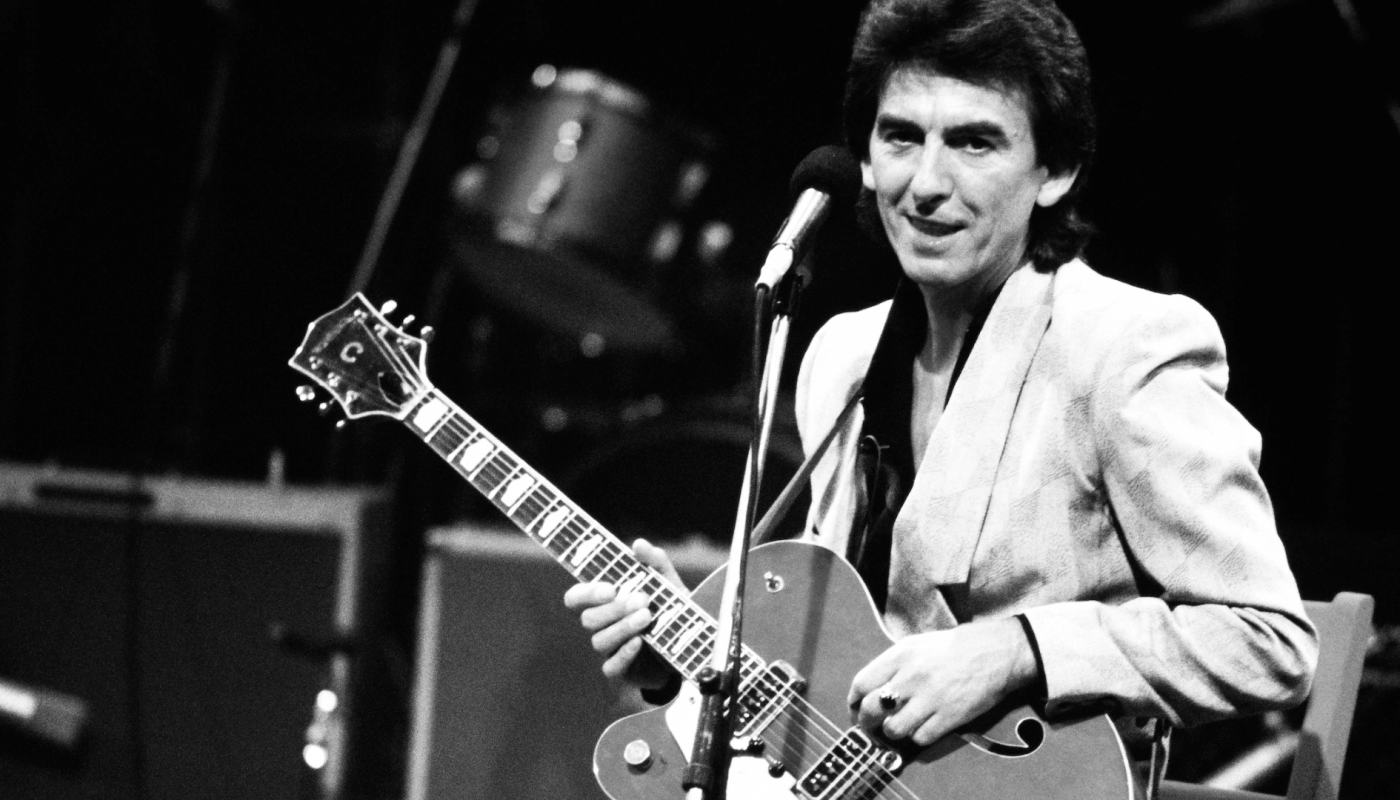

Michael van Voorst

Pour mieux comprendre le processus de clonage de la voix musicale avec so-vits-svc-fork (une version modifiée du so-vits-svc original), nous avons retrouvé Michael van Voorst, le créateur du modèle d’IA de la voix d’Elvis que Ballard a utilisé dans sa Baby Got Back vidéo. Il nous a expliqué les étapes nécessaires à la création d’un mash-up d’IA.

« Pour créer une réplique précise d’une voix, il faut commencer par créer un ensemble de données d’échantillons audio vocaux propres de la personne dont vous construisez le modèle vocal », explique M. van Voorst. « Les échantillons audio doivent être de qualité studio pour obtenir les meilleurs résultats. S’ils sont de qualité inférieure, cela se répercutera sur le modèle vocal. »

Dans le cas d’Elvis, van Voorst a utilisé des pistes vocales provenant de la célèbre chanson d’Elvis. Aloha From Hawaii en 1973, comme matériel de base pour l’entraînement du modèle vocal. Après un tri manuel minutieux, M. van Voorst a extrait 36 minutes de son de haute qualité, qu’il a ensuite divisé en morceaux de 10 secondes pour un traitement correct. « J’ai écouté attentivement pour détecter toute interférence, comme le bruit de la bande ou de l’auditoire, et je l’ai supprimée de mon ensemble de données », explique-t-il. Il s’est également efforcé de capturer une grande variété d’expressions vocales : « La qualité du modèle s’améliore avec des échantillons plus nombreux et plus variés.